Étant donné les développements très rapides des outils d’IA, ces lignes directrices peuvent être appelées à évoluer : il est essentiel que la communauté étudiante se tienne informée de cette évolution.

Face à l’intégration croissante des outils de l’intelligence artificielle (IA) dans les pratiques académiques et scientifiques, et notamment des outils d’IA générative (IAg) (i.e. ChatGPT d’OpenAI, Copilot de Microsoft, etc.), son utilisation se doit d’être réfléchie et de respecter les normes les plus strictes en matière d’intégrité intellectuelle et de recherche.

Balises institutionnelles pour une utilisation responsable de l’IA aux études

L’aide-mémoire suivant présente un survol des lignes directrices qui se retrouvent dans le document « Balises sur l’utilisation responsable de l’intelligence artificielle aux études supérieures » développé par le Service des études supérieures et de la réussite étudiante pour la communauté étudiante.

Aide mémoire

- Prioriser l’apprentissage académique : Utilisez l’IA comme un outil de soutien, qui ne doit pas se substituer au développement de vos compétences académiques essentielles telles que l’esprit critique, la recherche autonome et la rédaction.

- Obtenir une autorisation préalable : Vérifiez toujours si l’utilisation d’outils d’IA est permise dans un contexte donné. Consultez les politiques institutionnelles et les consignes spécifiques pour éviter tout usage inapproprié.

- Assumer la responsabilité du contenu généré : Prenez la responsabilité complète de tout contenu produit à l’aide de l’IA. Validez systématiquement l’exactitude, la pertinence et l’originalité des informations avant leur intégration dans vos travaux.

- Comprendre les risques associés : Soyez conscient des risques potentiels, notamment : a. Confidentialité : Les données sensibles ou personnelles peuvent être compromises. b. Plagiat : Le contenu généré peut inclure des éléments non originaux sans attribution claire. c. Cybersécurité : Certains outils d’IA peuvent exposer vos informations à des cyberattaques. d. Biais algorithmiques : Les résultats produits peuvent refléter des préjugés présents dans les données d’entraînement.

e. Enjeux environnementaux : l’empreinte environnementale de ces outils est à considérer pour en assurer une utilisation éco-responsable.

Gardez un esprit critique et faites preuve de transparence lorsque vous utilisez des outils de l’intelligence artificielle.

Notions de base

Intelligence artificielle (IA)

« L’intelligence artificielle (IA) désigne l’ensemble des techniques qui permettent à une machine de simuler l’intelligence humaine, notamment pour apprendre, prédire, prendre des décisions et percevoir le monde environnant. Dans le cas d’un système informatique, l’intelligence artificielle est appliquée à des données numériques. »

Source : Déclaration de Montréal, Glossaire, https://declarationmontreal-iaresponsable.com/glossaire

IA générative (IAg)

« C’est l’ensemble des techniques d’intelligence artificielle utilisées pour produire du contenu au moyen d’algorithmes et de mégadonnées, généralement sous forme de fichier texte, son, vidéo ou image. L’utilisation de l’intelligence artificielle générative peut mener au plagiat ou à la désinformation, notamment lorsqu’il s’agit de données issues de l’hypertrucage. Plus largement, les agents conversationnels intelligents sont des types d’intelligence artificielle générative. »

Source : Office québécois de la langue française, Grand dictionnaire terminologique, https://vitrinelinguistique.oqlf.gouv.qc.ca/fiche-gdt/fiche/26561649/intelligence-artificielle-generative

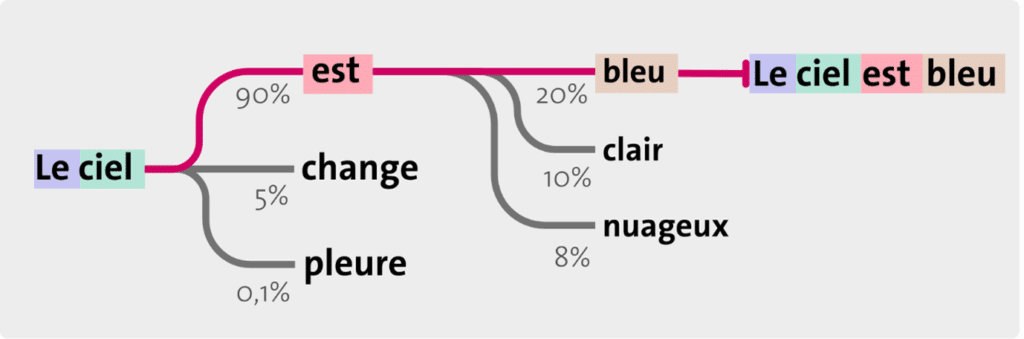

« Ce que l’on entend par le terme de « générative » est la capacité de l’IA à créer de l’information de manière automatique à partir de grands volumes de données existantes sur lesquelles elle est entraînée. L’IA ne fait pas de simple copier-coller de ce qu’elle a analysé : elle imite, améliore et crée un résultat entièrement nouveau, basé sur une recomposition statistique des motifs et structures qu’elle a identifiés pendant son apprentissage. Ces résultats, que l’on appelle contenus, peuvent être des textes, des images, de la musique ou du code informatique. »

Source : Université de Genève, Intelligence artificielle générative: Guide à l’intention de la communauté universitaire, Introduction à l’IA générative https://www.unige.ch/numerique/ia-generative-guide-unige/introduction-ia-generative

Différencier l’IA et l’IAg

Grand modèle de langage (LLM ou large language model)

« Un LLM est large, car il possède énormément de paramètres (de l’ordre de plusieurs milliards), qui sont autant de pièces d’information. C’est un modèle, car il s’agit d’un réseau de neurones entraîné sur une grande quantité de textes pour produire des tâches non spécifiques. Il est linguistique, car il reproduit la syntaxe et la sémantique du langage naturel humain en prédisant la suite probable pour une certaine entrée. Cela lui permet également d’avoir une « connaissance » générale sur la base des textes d’entraînement. »

Source : Intelligence artificielle générative. Guide pratique de l’UNIGE. Introduction à l’intelligence artificielle générative. Université de Genève.

Enjeux et limitations

Lorsque vous utilisez un outil d’IA, soyez conscient des enjeux et limitations liés à l’IA et réfléchissez à cette utilisation : est-elle appropriée et responsable ?

Substitution au développement de compétences essentielles : L’utilisation de l’IA doit être un outil complémentaire et non un substitut au travail intellectuel. Elle ne doit pas compromettre l’acquisition de compétences académiques essentielles telles que l’analyse critique, la rédaction, la recherche ou la résolution de problèmes.

Protection des données sensibles : Les données personnelles, confidentielles ou inédites, comme les résultats de recherche, ne doivent jamais être partagées avec des outils d’IA sans une approbation explicite. Ces outils peuvent stocker ou analyser les données de manière imprévisible, ce qui peut engendrer des risques sérieux pour la confidentialité et la cybersécurité. À noter : toutes les utilisations impliquant des données sensibles doivent être conformes à la Politique sur la gouvernance en matière de protection des renseignements personnels de l’INRS

Risque de cybersécurité : le partage de données via des plateformes d’IA en ligne peut exposer les utilisateurs à des cyberattaques ou à des violations de données.

Biais algorithmique et fiabilité des réponses : Les outils d’IA ne garantissent pas l’exactitude ou l’objectivité des réponses générées. De plus, les résultats générés par ces outils peuvent refléter des biais présents dans les bases de données d’entraînement, ce qui peut affecter la diversité et l’inclusivité des réponses.

Propriété intellectuelle et plagiat : L’intégration de contenu généré par les outils d’IA peut engendrer des violations potentielles des droits de propriété intellectuelle tels que le droit d’auteur. Les outils d’IA peuvent s’appuyer sur des données ou des œuvres protégées sans en garantir l’usage licite, ce qui expose les utilisateurs à des litiges. L’utilisation des outils d’IA doit être faite dans le respect des règles concernant les citations, les références et l’attribution des sources.

Enjeux environnementaux et humains : Les outils d’IA ont des impacts directs et indirects sur l’environnement (i.e. extraction des matières premières nécessaires pour fabriquer les équipements d’IA, consommation d’eau pour refroidir les serveurs et d’énergie pour entrainer les outils d’IAg, etc.) mais aussi sur la société, notamment le marché du travail (i.e. automatisation de certaines tâches, nouvelles compétences pour les employés, etc.).

Ressources et références

Voir tout

Ressources

- Balises sur l’utilisation responsable de l’IA aux études supérieures (pdf) – version anglaise (pdf)

- Fiche de déclaration d’utilisation de l’IAg (doc)

- Declaration form – use of generative artificial intelligence (doc)

Sources consultées pour les balises

- Université de Montréal, Lignes directrices pour une utilisation appropriée de l’intelligence artificielle (IA) générative aux études supérieures à l’Université de Montréal, É.s.e. postdoctorales, Editor. 2024, Université de Montréal, en ligne https://esp.umontreal.ca/fileadmin/esp/documents/PDF/Lignes_directrices_Utilisation_IA_Memoire_et_these_Octobre2024.pdf [consulté le 15 janvier 2025]

- Université de Sherbrooke, Lignes directrices pour l’utilisation de l’intelligence artificielle générative à l’Université de Sherbrooke, en ligne https://www.usherbrooke.ca/decouvrir/a-propos/priorites-institutionnelles/intelligence-artificielle/lignes-directrices-iag [consulté le 3 février 2025]

- Conseil supérieur de l’éducation et Commission de l’éthique en science et en technologie (2024). Intelligence artificielle générative en enseignement supérieur : enjeux pédagogiques et éthiques, Québec, Le Conseil; La Commission. En ligne https://www.cse.gouv.qc.ca/publications/ia-enseignement-sup-50-0566/ [consulté le 15 janvier 2025]

- Université de Genève, Introduction à l’IA générative de l’Université de Genève – en ligne https://www.unige.ch/numerique/fr/plan-daction/ia1/accueil/guide-pratique-ia/introduction-lia-generative/ [consulté le 3 mars 2025]

- Université du Québec. (2025). Énoncé de principes sur l’utilisation responsable de l’intelligence artificielle générative dans les activités de formation et de recherche. Vice-présidence à l’enseignement et à la recherche

Quelques glossaires de l’IA (liste non exhaustive)

- Gouvernement du Canada, Carte conceptuelle de la terminologie de l’intelligence artificielle (IA)

- Office québécois de la langue française, Une intelligence artificielle bien réelle : Les termes de l’IA

- Déclaration de Montréal IA responsable, Glossaire

- Observatoire international sur les impacts sociétaux de l’IA et du numérique (Obvia), Glossaire

- Frise historique de l’IA tiré du Mooc Intelligence artificielle pour et par les enseignants, plateforme FUN https://view.genially.com/64e486d0efc8e200198a554b

Ressources additionnelles et outils

- TÉLUQ : Étudier à l’ère de l’IA – Parlons intégrité… et plagiat – Cette page web présente plusieurs bonnes pratiques, ressources et cas de figure en lien avec l’IA et l’intégrité intellectuelle

- Université de Montréal : https://bib.umontreal.ca/evaluer-analyser-rediger/iag – cette page propose des repères pour une utilisation responsable d’IAg en contexte académique

- Université du Québec en Outaouais – https://pupp.uqo.ca/fr/intelligence-artificielle-et-plagiat/ – cette page web regroupe des articles, des pistes de solutions et des recherches sur l’intelligence artificielle, le plagiat et l’intégrité intellectuelle

- HEC, Comment utiliser l’intelligence artificielle générative de manière responsable, https://www.hec.ca/etudiants/soutien-ressources/intelligence-artificielle-generative/utilisation-responsable/index.html [consulté le 29 avril 2005] – cette page web présente de bonnes pratiques pour intégrer l’IAg de manière responsable et alignée avec les exigences académiques

- Billet 6 – La recherche assistée par l’IA – Faculté des arts et des sciences – Université de Montréal [consulté le 3 mars 2025] – ce billet traite du potentiel d’utilisation de l’IA en recherche et en pédagogie et des défis associés

- Durabilité à l’Ère du Numérique – L’IA et l’environnement : une arme à double tranchant [consulté le 2 mai 2025] – cette publication présente les avantages, les enjeux et des solutions en regard de l’IA et de l’environnement

- LiterIA – Outils et tutoriels https://literatia.ca/outils-et-tutoriels/ [consulté le 3 mars 2025] – cette page regroupe de courtes capsules vidéos sur divers sujets en lien avec l’IA : comprendre ChatGPT pour les débutants, génération de texte, génération d’image.

Des questions? Contactez-nous à l'adresse suivante